A Fundação Molly Rose está pedindo um novo Projeto de Lei de Segurança Online para fortalecer a regulação de conteúdo.

Estudo revela falhas na moderação de conteúdo

Um novo estudo apontou que algumas das maiores plataformas de mídia social não conseguem detectar e remover conteúdo perigoso relacionado ao suicídio e automutilação. A pesquisa, realizada pela Fundação Molly Rose, analisou mais de 12 milhões de decisões de moderação de conteúdo feitas por seis grandes plataformas. Os resultados mostram que mais de 95% dessas ações foram realizadas por apenas dois sites: Pinterest e TikTok.

Instagram e Facebook com baixo desempenho

A pesquisa revelou que o Instagram e o Facebook, ambos pertencentes à Meta, foram responsáveis por apenas 1% de todo o conteúdo de suicídio e automutilação detectado. O X, anteriormente conhecido como Twitter, teve uma taxa ainda menor, sendo responsável por uma em cada 700 decisões de moderação.

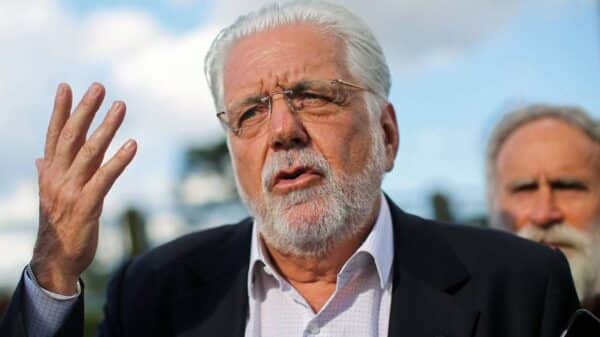

Reação da Fundação Molly Rose

Ian Russell, presidente da Fundação Molly Rose, criticou a ineficiência das plataformas. Segundo ele, pais em todo o país ficam indignados ao descobrir que plataformas como Instagram e Facebook prometem medidas, mas continuam expondo crianças a perigos evitáveis. Ele defende a necessidade de uma ação assertiva para proteger os jovens.

Necessidade de uma nova regulamentação

A Fundação alertou que a atual Lei de Segurança Online não é suficiente para corrigir as falhas sistemáticas na moderação de conteúdo das redes sociais. Russell pediu ao governo que se comprometa com um novo Projeto de Lei de Segurança Online, capaz de reforçar a regulamentação e proteger melhor os usuários.

Impacto da ineficiência das plataformas

O relatório da Fundação destaca que as redes sociais frequentemente falham em detectar conteúdo prejudicial nas áreas de maior risco de suas plataformas. Por exemplo, apenas um em cada 50 posts de suicídio e automutilação detectados pelo Instagram era um vídeo, mesmo com o recurso de vídeos curtos Reels representando metade do tempo gasto no aplicativo.

Regras não aplicadas de forma consistente

O estudo também aponta que as plataformas não estão aplicando consistentemente suas próprias regras. O TikTok, por exemplo, detectou quase três milhões de itens de conteúdo prejudicial, mas suspendeu apenas duas contas.

Respostas das plataformas

Um porta-voz da Meta afirmou que o conteúdo que incentiva suicídio e automutilação viola suas regras e que, no último ano, a empresa removeu 50,6 milhões de conteúdos desse tipo em todo o mundo. No entanto, na União Europeia, a empresa não pode implementar todas as suas medidas de proteção.

O Snapchat também se pronunciou, destacando que a segurança e o bem-estar de sua comunidade são prioridades máximas. A plataforma afirmou que, ao identificar conteúdo prejudicial, ele é removido rapidamente e as medidas adequadas são tomadas.

Mais em Portal Notícia Tem.